Viele Webseitenbetreiber haben diese Beobachtung schon lange gemacht. Wie das amerikanische Online Marketing Blog searchengineland.com geschrieben hat, will Google mit der Argumentation, die Google-Such in Zeiten von PRISM, diskreter zu gestalten, keine Reports mehr ermöglichen, die erkennen lassen, mit welchen Suchbegriffen ein Besucher auf die eigene Website gelangt ist. Auch wenn dies nicht ganz überraschend kommt, ein Schlag in die Magengrube von Webseitenbetreibern und Suchmaschinenoptimierern ist es dennoch. Wie erfahren wir denn nun, mit welchen Keywords die User auf der Seite landen?

Viele Webseitenbetreiber haben diese Beobachtung schon lange gemacht. Wie das amerikanische Online Marketing Blog searchengineland.com geschrieben hat, will Google mit der Argumentation, die Google-Such in Zeiten von PRISM, diskreter zu gestalten, keine Reports mehr ermöglichen, die erkennen lassen, mit welchen Suchbegriffen ein Besucher auf die eigene Website gelangt ist. Auch wenn dies nicht ganz überraschend kommt, ein Schlag in die Magengrube von Webseitenbetreibern und Suchmaschinenoptimierern ist es dennoch. Wie erfahren wir denn nun, mit welchen Keywords die User auf der Seite landen?

Wer regelmäßig seinen Webseitentraffic analysiert, wird gesehen haben, dass der Anteil der nicht zuordenbaren Suchanfragen (in Google Analytics „not provided“) stetig ansteigt.

Google teilt die Suchanfragen nicht mehr im Referrer mit

Die Kurve mit den Zahlen der Besuche durch die organische Suche und die Kurve für die Anzahl unbekannter Suchbegriffe nähern sich schon lange kontinuierlich an.

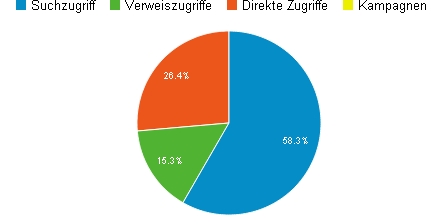

Dazu reicht ein Blick in die Sektion „Besucherquellen > Übersicht“. Dabei ist die organische Suche (in Abgrenzung zu bezahlten Suche, also Google Adwords) wohl bei der Mehrzahl aller Site die wichtigste Trafficquelle.

Demnächst dürfte dieser Block derjenige sein, über den man als Webmaster oder Webanalyst zunächst am wenigsten weiß.

Schon lange hat Google damit begonnen, die Such-Keywords zu verschleiern. Anfangs handelte es sich um Suchanfragen, die von Usern kamen, die in Google eingeloggt waren. Jetzt soll der gesamte Suchtraffic betroffen sein.

An dieser Beispiel-Grafik von einer echten Website sieht man eine Annäherung der Kurve aller Besucher durch die Google Suche (blaue Linie) an die Linie mit der Anzahl der von Besuchern, die über einen nicht mehr ausgewiesenen Suchbegriff auf der Domain landeten (orange Linie). Abgesehen davon, dass in diesem Beispiel immer weniger Besucher auf diese Website über die Google Suche gekommen sind (was hier aber nicht das Thema ist), werden sich beide Linien bald vereinigen.

Mit anderen Worten: Bald wird der Anteil nicht zugeordneter Suchbegriffe 100 Prozent betragen. Das hat Google inzwischen auch bestätigt.

Jedes Analysetool, das sich auf Referrer bezieht, ist betroffen

Übrigens sind auch andere Analysetools betroffen, nicht nur Google Analytics, Piwik, etracker und Co. haben das gleiche Problem, weil in den Referrern die Information nichtmehr vorhanden ist.

Ob das Analysetool den Referrer gleich abfängt (meist über eine Scriptintegration im Webseitencode oder durch die Filterung der Logfiledaten), ist egal. Die Information ist einfach nicht mehr vorhanden.

Ein Referrer von Google sieht im Server-Logfile (Auschnitt) so aus:

Es steht also nur noch „https://www.google.de/“ als Referrer im Logfile.

Bei Bing ist das übrigens anders: Hier steht die Suchphrase bzw. das Keyword im Referrer (blau markiert, ich habe nach meinem Namen gesucht):

Die Bing-Suche liefert im Referrer die Suchphase noch mit

Wir sehen also, dass Suchanfragen von Bing, die auf der Site landen noch ausgewertet werden können, um das Keyword zu ermitteln.

Das Problem hierbei für diese eigentlich gute Nachricth ist nur: Der Marktanteil der Bing Suche beträgt in Deutschland um die drei Prozent. Die Google Suche dominiert nicht nur, sie ist marktbeherrschend – die Deutschen lieben ihre Monopole…

Anti-PRISM-Maßnahme?

Google bezeichnet diese Änderung als eine „Post-PRISM“-Maßnahme:

https://searchengineland.com/post-prism-google-secure-searches-172487

Kaum jemand nimmt Google ab, dass man sich tatsächlich hauptsächlich Sorgen um den Datenschutz der Nutzer der Google-Suche macht.

Der wahre Grund, so vermuten viele, wird eher der Versuch sein, das Adwords-Programm weiter zu beflügeln. Wer Adwords bucht, erhält nach wie vor Angaben darüber, mit welchen Suchbegriffen die User auf der Website landen. Natürlich kostet Adwords Geld – pro Klick eine Summe, die hauptsächlich davon abhängt, wie viele andere Anbieter Anzeigen präsentieren wollen, die erscheinen, wenn jemand mit einem festgelegten Keyword oder einer ganzen Phrase etwas mit Google sucht. Der Klickpreis kann 30 Cent betragen oder auch mal 10 Euro – je nach Begriff oder Phrase.

Was bleibt also, um herauszufinden, mit welchen Keywords User auf der eigenen Website landen?

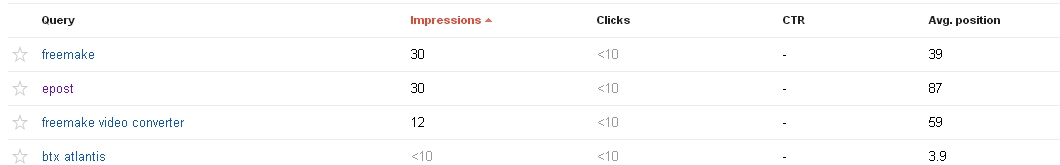

Zum einen gibt es die Google Webmaster Tools. Auch hier werden Suchbegriffe gezeigt, die dazu führen, dass die entsprechende Domain in der Suchergebnisliste auftaucht. Ausgangspunkt ist aber, Informationen darüber zu vermitteln, welche Keywords eine Anzeige der untersuchten Domain in der Suchergebnisliste ausgelöst haben.

Hier werden immer noch Keywords gezeigt, allerdings in einer stark vergröberten Form, was bei kleinen Sites zu Problemen führt, siehe Beispiel:

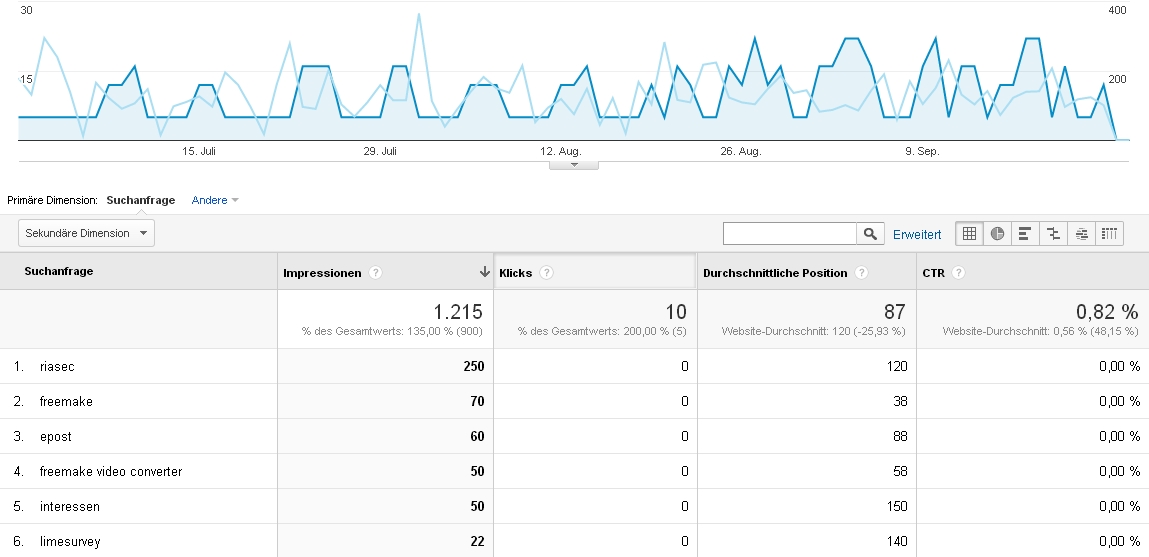

Wie wir wissen, lässt sich Google Analytics gut mit den Webmastertools verbinden. Der entsprechende Menüpunkt in Google Analytics heißt „Suchmaschinenoptimierung“. Dort sieht die Integration der Daten also so aus:

Der große Block „not provided“ taucht hier also gar nicht auf. Man bekommt durch die Webmastertools keine Darstellung darüber, wie groß der Anteil der Besuche durch einzelne Keywords oder Keywordgruppen durch Suchanfragen am Gesamttraffic ist. Das erschwert natürlich die Optimierung etwas.

Als Seitenbetreiber kann man auch nur noch entsprechend schwerer abschätzen, welche Keywords für irgendeine Conversion gesorgt haben.

Was bleibt noch, um eine Recherche nach wichtigen Keywords zu betreiben, also um herauszufinden, welche Keywords für die Seite wichtig sind und welche Interaktion diese auf der Site auslösen?

Scraping der Suchergebnisseiten

Man kann die Google Suchergebnisseiten nach eigenen relevanten Keywords durchsuchen und ermitteln, welche URL als Suchergebnis gezeigt worden ist. Das heißt, man muss massenhafte Anfragen an Google schicken und die Suchergebnisse auf die eigene Domain filtern. Dies ist die Ermittlung der Sichtbarkeit der eigenen Domain bezogen auf bestimmte Keywords – schließlich kann man nicht alle Google Suchergebnisseiten speichern und analysieren. Grund: Es gibt zu viele verschiedene Suchanfragen und Google mag kein „Scraping“ seiner Suchergebnisseiten. Wer so etwas tut, wird sehen, dass die IP von Google recht schnell geblockt wird. Eine Vorstufe ist die Abfrage über ein Captcha, um zu ermitteln, ob ein Mensch vor dem Screen sitzt oder ein Algorithmus am Werk ist.

Ausweg Google Webmaster Tools?

Hilfreich kann es zudem sein, die Angaben aus Analytics mit denen aus den Webmastertools vergleichen. In den Webmastertools werden Impressions und Clicks für die Top-Keywords gezeigt. Was für die Webmastertools die „Clicks“ sind, ist für Analytics ein „Visit“.

Leider hat Google Webmaster Tools auch noch – neben der groben Darstellung – den Nachteil, dass keine historischen Daten gespeichert werden. Man hat als User nur auf ein Zeitfenster von einigen Wochen Zugriff. Dennoch wäre es gut, man speichert sich die Report regelmäßig, nicht mehr gezeigte Daten sind aber verloren.

Einen zum Google Webmaster Tool Suchanfragenreport ähnlichen Bericht kann man sich in der Bing Webmaster Zentrale anzeigen lassen.

Bleibt nur noch die Frage offen, wie lange Google die Analyse der Suchbegriffe über die Webmaster Tools zulässt. Wäre ja eigentlich nur eine logische Konsequenz, auch hier die Informationen zu anonymisieren, oder nicht? …

Ich habe gesehen, dass einige Toolhersteller nun bereits Lösungen anbieten. Mit einem Scraping der Serps (Suchmaschinenergebnisseiten) kann man der Trafficverteilung ja schon recht nahe kommen.

Man weiß ja grundsätzlich dadurch, welche Seiten zu welchen Keywords die Google Suche anbietet.

Ja nur sagst du selbst, dass Google das Scrapen ihrer Suchergebnissseiten nicht mag. Da werden sie sich früher oder später auch dagegen wehren.

Auf der anderen Seite benötigt Google ja eine möglichst große Menge an aktuellen Webseiten mit viel Content, damit man überhaupt eine Suchmaschine braucht.

Wenn sich alles zu sehr konsolidiert, ist eine globale Suchmaschine überflüssig. Google hat also interesse an einem „unüberschaubarem“ Web.

Daher ist es ja auch im Interesse von Google, Möglichkeiten für Optimierungen anzubieten. Die Webmastertools sind ja genau deswegen entstanden. Den SEOs sind „nur“ die Möglichkeit genommen worden, einzelne Seiten für bestimmte Keywords so leicht zu optimieren.